Donald D. Hoffman geht in seinem Buch The Case Against Reality: Why Evolution Hid the Truth from Our Eyes sogar noch einen Schritt weiter. Er vertritt die These, dass unser Gehirn in einem evolutionären Prozess jene Strategien bevorzugt hat, die das Überleben sichern – und nicht unbedingt diejenigen, die uns eine objektive Wirklichkeit oder gar Wahrheit offenbaren. Was wir für real halten, ist in Hoffmans Augen eine Art „Benutzeroberfläche“, optimiert für effektives Handeln statt für Wahrheitsfindung. Unser Geist täuscht uns also manchmal bewusst, damit wir mit minimalem Aufwand maximale Vorteile erzielen können. Diese Idee passt gut zu der kognitionswissenschaftlichen Perspektive, wonach Wahrnehmung und Denken stark durch biologische und psychologische Faktoren geprägt sind.

Ein Blick in den Alltag zeigt, dass wir selten die „ganze Wahrheit“ benötigen, um in der entsprechenden Situation zu agieren. Schon bei einfachen optischen Täuschungen wird deutlich, wie selektiv unsere Wahrnehmung sein kann. Linien wirken plötzlich verbogen, obwohl sie geradlinig sind. Farben scheinen sich zu verändern, obwohl sie konstant bleiben. Unser Gehirn setzt in Bruchteilen von Sekunden Filter, Heuristiken und Mustererkennungen ein, die in 99% der Fälle ausreichend sind – und gelegentlich für erstaunliche Fehlinterpretationen sorgen.

Eben diese Neigung, die Welt stark vereinfacht abzubilden, tritt nun im digitalen Zeitalter nochmals stärker hervor. Künstliche Intelligenz ist in der Lage, Bilder zu generieren, die so realitätsnah wirken, dass sie uns regelrecht täuschen. Deepfakes sind nur ein Beispiel dafür, wie sehr computergenerierte Inhalte unsere Sinne austricksen können. Wenn wir nicht einmal mehr unseren eigenen Augen trauen können, drängt sich die Frage auf: Ist das, was wir sehen, wirklich real oder nur eine technologisch erzeugte Projektion?

Auch wenn Algorithmen nicht „sehen“ oder „fühlen“ wie wir, so sind sie doch in ihrer eigenen Weise anfällig für Verzerrungen – ein Phänomen, das man als Bias in KI-Modellen bezeichnet. Genau an dieser Stelle wird deutlich, dass KI und menschliche Wahrnehmung mehr gemeinsam haben, als man zunächst denkt: Beide „konstruieren“ eine Wirklichkeit, basierend auf dem, was ihnen zur Verfügung steht. Hier kommt der Konstruktivismus ins Spiel – der philosophische Ansatz, wonach weder Menschen noch Maschinen eine objektive Wirklichkeit abbilden, sondern diese aktiv konstruieren durch die für sie zu Verfügung stehenden Mittel. Für den Menschen sind es Sinneseindrücke und Erfahrungen, für die Maschine sind es Trainingsdaten und Algorithmen.

In meiner eigenen Forschung habe ich mich mit dem Thema Bias in Bilderkennungssystemen beschäftigt. Ein konkretes Beispiel dafür ist das Projekt GANDiffFace: Controllable Generation of Synthetic Datasets for Face Recognition. Dabei konnten wir zeigen, wie subtil bereits der Datensatz selbst – also die visuelle „Realität“, mit der ein Algorithmus gefüttert wird – die Wahrnehmung und das Urteilsvermögen eines KI-Systems formen kann. Verzerrte oder unausgewogene Datensätze führen zu algorithmischen „blind spots“, die in manchen Fällen Menschengruppen benachteiligen oder bestimmte Gesichter weniger genau erkennen. Maschinen erkennen dann vermeintlich „falsche“ Muster oder kommen zu voreingenommenen Schlüssen, ähnlich wie wir Menschen durch selektive Wahrnehmung zu Fehlschlüssen neigen.

Folgt man dem Konstruktivismus so zeigt sich hier ganz deutlich, dass weder menschliche noch maschinelle „Wahrnehmung“ jemals perfekt sein kann – beides sind Interpretationen und Vereinfachungen einer komplexen Wirklichkeit. Während wir Menschen uns auf biologische Sinne stützen, die Informationen filtern und bewerten, nutzen KI-Systeme mathematische Modelle und Daten, um ein internes Abbild der Welt zu erzeugen. Doch sowohl im menschlichen Gehirn als auch im neuronalen Netz einer Maschine können Fehler, Vorurteile und Verzerrungen entstehen. In der Philosophie wirft das die Frage auf, ob es überhaupt möglich ist, etwas wie „objektive Realität“ zu erfassen – oder ob wir stets in einem Konstrukt leben, das sowohl biologisch als auch technologisch geprägt ist.

Wenn KI in ihrer „Wahrnehmung“ verzerrt ist, bedeutet das nicht zwingend, dass sie dem Menschen überlegen oder unterlegen ist. Es heißt vielmehr, dass wir genau hinschauen müssen, wie Daten erhoben und Modelle trainiert werden, um gerechtere und präzisere Systeme zu bauen. Genauso wie wir uns selbst hinterfragen sollten, ob unsere Sinne und Denkmuster uns in die Irre führen, sollten wir algorithmische Prozesse in Frage stellen, bevor wir ihnen blind vertrauen. Ob im „Human Brain“ oder in neuronalen Netzen – Verzerrungen lassen sich nie ganz ausschließen. Doch wenn wir uns dieser Gemeinsamkeit bewusst sind, können wir verantwortungsvoller mit KI umgehen und hoffentlich besser verstehen, was unsere eigene Wahrnehmung zum wackeligen Fundament für unsere Vorstellung von „Realität“ macht.

Aus dieser Perspektive öffnet sich ein spannender Raum zwischen Philosophie und Technologie, in dem wir uns fragen können, ob die durch KI erzeugten Illusionen am Ende sogar zu einem tieferen Verständnis menschlicher Kognition führen. Schließlich könnte das Erforschen maschineller Biases uns helfen, unsere eigenen kognitiven Verzerrungen klarer zu sehen – und damit ein Stück näher an jene „Wirklichkeit“ zu kommen, die wir so oft nur als Schatten an der Wand unserer Wahrnehmung wahrnehmen.

Der Gedanke, dass unser Gehirn von Natur aus „beschränkt“ und gezielt irreführend konstruiert sein könnte, klingt zunächst frustrierend. Andererseits lässt sich daraus auch eine gewisse Freiheit ableiten: Wer sich bewusst macht, dass die eigene Wahrnehmung gefärbt ist, kann ein tieferes Verständnis für unterschiedliche Perspektiven entwickeln. Genau an dieser Schnittstelle zwischen Illusion und Erkenntnis lohnt es sich, weiterzudenken. Denn wenn wir erkennen, dass uns unsere Sinne täuschen, ist das zugleich der erste Schritt, um den Nebel unserer Sinne zumindest ein Stück weit zu lichten.

Im täglichen Miteinander nehmen wir meist an, unser Blick auf die Welt sei verlässlich und klar. Erst wenn sich etwas Unvorhergesehenes ereignet – etwa eine faszinierende optische Täuschung – merken wir, wie leicht sich unsere Wahrnehmung ins Wanken bringen lässt. Magische Kunststücke, Werbekampagnen und auch künstlerische Installationen nutzen genau diese Schwächen aus. Sie spielen mit Kontrasten, Perspektiven und Farben, damit unser Gehirn falsche Schlüsse zieht. Manchmal sehen wir dabei sogar Dinge, die gar nicht existieren, oder erkennen in scheinbar abstrakten Mustern vertraute Figuren.

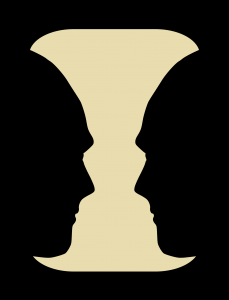

Ein klassisches Beispiel ist die Rubin’sche Vase, bei der wir entweder eine Vase oder zwei einander zugewandte Gesichter wahrnehmen können – aber nie beides gleichzeitig. Das zeigt anschaulich, wie unser Gehirn ständig versucht, Ordnung in das visuelle Chaos zu bringen, indem es Muster interpretiert und ergänzt. Ähnliche Phänomene findet man in der Müller-Lyer-Illusion, wo zwei Linien in identischer Länge plötzlich völlig verschieden erscheinen, nur weil sie von unterschiedlich angeordneten Pfeilspitzen umrahmt werden. Solche Effekte verdeutlichen, dass unsere Augen nicht lügen, aber das Gehirn die eintreffenden Sinnesdaten auf vielfältige Weise verarbeitet, vereinfacht und bewertet.

Gerade weil wir dazu neigen, unsere Wahrnehmung für objektiv zu halten, entsteht ein Spannungsfeld zwischen dem, was wir „tatsächlich“ sehen und dem, was das Gehirn uns glauben lässt, zu sehen. Dieser Mechanismus hat in der Evolutionsbiologie seine Berechtigung: Er hilft uns, uns schnell in unserer Umwelt zu orientieren, ohne unser Gehirn mit zu vielen Details zu überfordern. Dabei verzichtet unser Denkorgan unter Umständen auf eine exakte Abbildung der Welt. Wie es Donald D. Hoffman formuliert: Der Erfolg im Überlebenskampf stand evolutionär an erster Stelle, nicht die minutiöse Wahrheitsfindung.

In der modernen Gesellschaft werden solche Illusionen zusätzlich technologisch verstärkt: Virtual Reality und Augmented Reality lassen uns in immersive Szenerien eintauchen, deren Details so wirklichkeitsnah wirken, dass wir schlicht vergessen, uns in einer simulierten Umgebung zu bewegen. Was als Spielerei begonnen hat, nutzt heute bereits die Medizin, um beispielsweise bei Phobietherapien „realitätsnahe“ Konfrontationen zu erzeugen. Ob illusorische Feinde oder künstlich erzeugte Traumwelten – unser Gehirn akzeptiert blitzschnell, was es sieht, und fällt so immer wieder auf dieselbe Weise auf seine eigenen Mechanismen herein.

Doch warum ist das wichtig? Wer im Bereich von Künstlicher Intelligenz arbeitet, weiß, dass das Zusammenspiel zwischen menschlicher Wahrnehmung und digitalen Werkzeugen immer komplexer wird. Forschungsrichtungen wie die angewandte Kognitionswissenschaft zeigen, wie sehr unsere Sinne und unser Denken von unbewussten Filtern, Erfahrungen und Erwartungen beeinflusst sind. Das eröffnet ungeahnte Möglichkeiten für Anwendungen, von virtuell begleiteten Trainings bis hin zu KI-Systemen, die uns bestimmte Perspektiven vorschlagen oder verbergen. Gleichzeitig trägt es jedoch die Gefahr in sich, dass wir uns in einem Wirrwarr aus Illusionen verlieren – wenn wir nicht lernen, die eigenen Wahrnehmungsgrenzen kritisch zu reflektieren.

Die Auseinandersetzung mit unseren kognitiven Grenzen bei der Erkenntnis der Realität kann schmerzhaft sein – doch sie ist unerlässlich. Nur wenn wir unser Denken beständig hinterfragen und uns intellektuell weiterentwickeln, können wir die aktuelle technologische Revolution der Künstlichen Intelligenz in einen echten Fortschritt für die gesamte Menschheit verwandeln. Ein tieferes Verständnis unserer allzu fehleranfälligen, menschlichen „Realitäts-Hardware“ eröffnet uns den Weg zu noch ausgereifteren Algorithmen, die über die bloße Simulation künstlicher neuronaler Netze hinausgehen. Damit haben KI-Modelle das Potenzial, uns auf eine neue zivilisatorische Stufe zu heben – vorausgesetzt, wir sind bereit die Grenzen unseres eigenen Geistes immer wieder neu auszuloten.